Dlaczego karty graficzne są niezbędne dla sztucznej inteligencji?

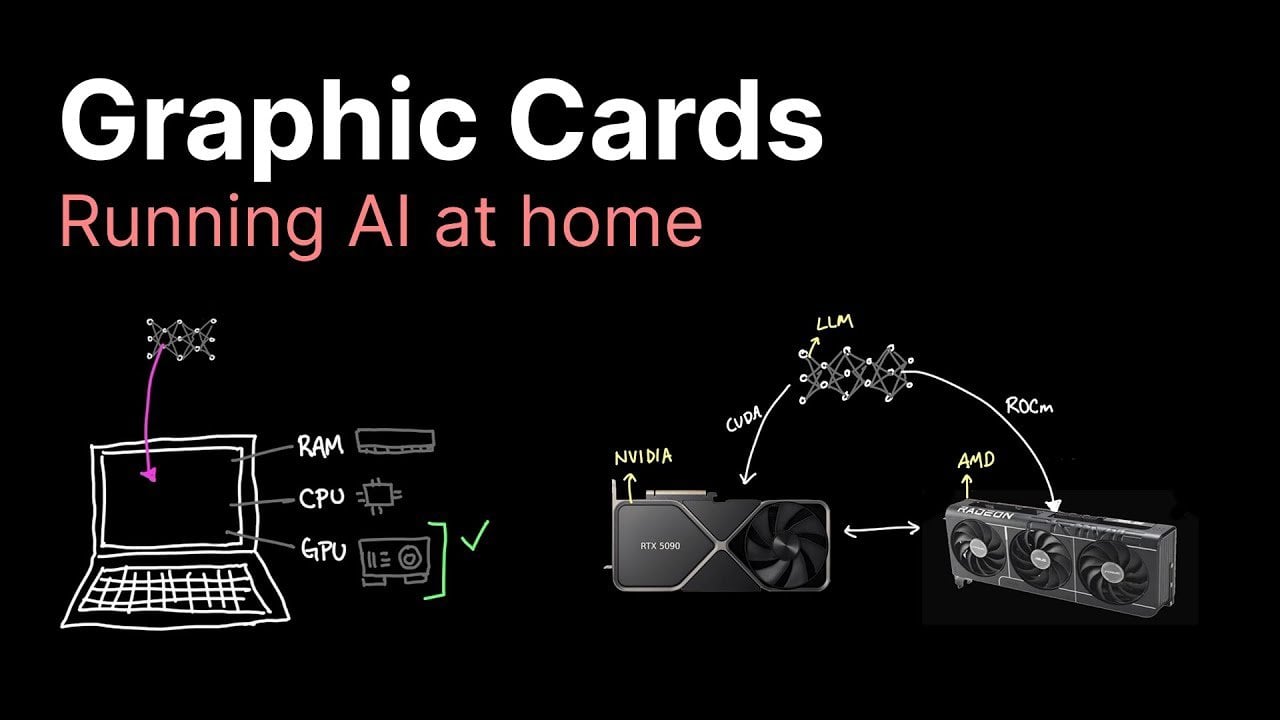

Podczas gdy procesory CPU doskonale radzą sobie z zadaniami sekwencyjnymi, ich architektura nie jest optymalna dla wymagających obliczeniowo modeli AI. Tutaj kluczową rolę odgrywają karty graficzne GPU, które dzięki zdolności do równoległego przetwarzania miliardów operacji jednocześnie, znacząco przyspieszają pracę ze sztuczną inteligencją. Dla mniejszych modeli CPU może jeszcze wystarczyć, jednak wraz ze wzrostem złożoności projektów, posiadanie wydajnej karty graficznej staje się koniecznością.

Autor artykułu podkreśla, że odpowiedni GPU decyduje o tym, czy obliczenia zajmą godziny, czy zaledwie sekundy. Bez dedykowanej karty graficznej zaawansowane modele AI mogą nie działać poprawnie lub ich uruchomienie będzie niemożliwe na lokalnym sprzęcie.

Przegląd kart graficznych w różnych przedziałach cenowych

Wybór optymalnej karty graficznej zależy głównie od Twojego budżetu oraz skali projektów AI, które planujesz realizować. Poniżej przedstawiamy przegląd dostępnych opcji:

W przedziale cenowym do 1500 zł znajdziemy modele takie jak GTX 1080 Ti czy RTX 3060. Sprawdzają się one przy mniejszych modelach, obsługując do około 10 miliardów parametrów. Ich ograniczeniem jest stosunkowo mała pamięć VRAM i moc obliczeniowa, co uniemożliwia pracę z większymi, bardziej złożonymi projektami.

W okolicy 4000 zł plasuje się popularna wśród entuzjastów AI karta RTX 3090 z 24 GB pamięci VRAM. Oferuje ona dobry balans między kosztem a wydajnością, obsługując modele do 30 miliardów parametrów i zapewniając niezawodne działanie w większości zastosowań.

Za około 8000 zł można nabyć RTX 4090, która oferuje wyższą moc obliczeniową przy jedynie nieznacznym wzroście pamięci VRAM w porównaniu do RTX 3090. Choć jej wydajność jest imponująca, wysoka cena nie zawsze przekłada się na adekwatny wzrost możliwości w kontekście AI.

Powyżej 12000 zł znajduje się RTX 5090 z 32 GB VRAM, zaprojektowana dla największych modeli i zaawansowanych zadań. Jednak jej koszt może być zbyt wysoki dla przeciętnego użytkownika, zwłaszcza że podobne rezultaty można często osiągnąć używając kilku kart ze średniej półki.

Alternatywę stanowią karty AMD, takie jak RX7900 XTX z 24 GB VRAM, które oferują atrakcyjny stosunek ceny do możliwości. Wymagają one jednak więcej pracy przy konfiguracji, ponieważ większość frameworków AI jest zoptymalizowana pod kątem technologii NVIDIA.

Kluczowe parametry wydajnościowe

Wybierając kartę graficzną do celów AI, należy zwrócić uwagę na kilka kluczowych specyfikacji:

Pamięć VRAM to jeden z najważniejszych parametrów. Bezpośrednio wpływa na to, jak duże modele AI jesteś w stanie uruchomić. Niewystarczająca ilość VRAM prowadzi do wąskich gardeł wydajnościowych lub całkowicie uniemożliwia uruchomienie modelu.

Moc obliczeniowa, określana przez liczbę rdzeni CUDA (dla kart NVIDIA) lub jednostek obliczeniowych (dla AMD), decyduje o szybkości przetwarzania danych. Wyższa wartość tego parametru przekłada się na szybsze wykonywanie zadań.

Technika kwantyzacji pozwala na redukcję precyzji parametrów modelu, co znacząco obniża zapotrzebowanie na zasoby. Chociaż może nieznacznie wpłynąć na dokładność wyników, jest to skuteczny sposób na uruchomienie większych modeli na sprzęcie z mniejszą ilością VRAM.

Przepustowość pamięci, czyli szybkość transferu danych wewnątrz karty, ma istotny wpływ na ogólną wydajność. Nawet najpotężniejsze karty mogą napotykać ograniczenia w tym obszarze, co hamuje pełne wykorzystanie ich możliwości.

Wynajem GPU w chmurze kontra sprzęt lokalny

Dla osób realizujących krótkoterminowe projekty AI lub dysponujących ograniczonym budżetem, atrakcyjną alternatywą może być wynajem mocy obliczeniowej w chmurze. Usługi takie jak Lambda czy Coreweave zapewniają dostęp do wysokowydajnych kart graficznych bez konieczności ponoszenia jednorazowych, wysokich nakładów inwestycyjnych. To doskonałe rozwiązanie do testowania modeli lub obsługi tymczasowych, intensywnych obliczeniowo zadań.

Jednak dla długoterminowych przedsięwzięć lub projektów związanych z wrażliwymi danymi, inwestycja w lokalny sprzęt okazuje się zazwyczaj bardziej opłacalna i bezpieczna. Posiadanie własnego GPU daje pełną kontrolę nad danymi i eliminuje cykliczne koszty abonamentowe związane z usługami chmurowymi.

Przyszłe trendy i dodatkowe uwagi

Rosnące zapotrzebowanie na prywatność danych i customizację modeli napędza popularność lokalnego przetwarzania AI. Inwestycja w kartę graficzną dziś, przygotowuje Cię nie tylko na obecne, ale także przyszłe wymagania technologii sztucznej inteligencji.

Autor zwraca uwagę na kilka istotnych kwestii. Zakup używanych kart, szczególnie tych wcześniej wykorzystywanych do kopania kryptowalut, może wiązać się z ryzykiem skróconej żywotności sprzętu z powodu zużycia. Chociaż wysokiej klasy modele takie jak RTX 4090 czy 5090 oferują ogromną moc, mogą nie być opłacalne dla użytkowników domowych lub małych projektów. W przypadku rozbudowanych systemów, często lepszym rozwiązaniem jest zastosowanie kilku kart ze średniej półki, co zapewnia lepszą skalowalność i elastyczność przy często niższym całkowitym koszcie.

Dobór odpowiedniego GPU to zawsze balans między budżetem, wymaganiami wydajnościowymi i długoterminowymi celami. Podczas gdy starsze karty poradzą sobie z mniejszymi modelami, te bardziej złożone będą wymagały zaawansowanego sprzętu. Dla osób szczególnie wrażliwych na koszty, karty AMD lub usługi chmurowe stanowią wartościową alternatywę. Inwestując świadomie w odpowiedni sprzęt, zyskujesz zarówno elastyczność, jak i kontrolę nad swoimi projektami AI.

Artykuł został przygotowany na podstawie analizy materiałów Caleba, który szczegółowo badał wydajność różnych kart graficznych w kontekście uruchamiania modeli sztucznej inteligencji.