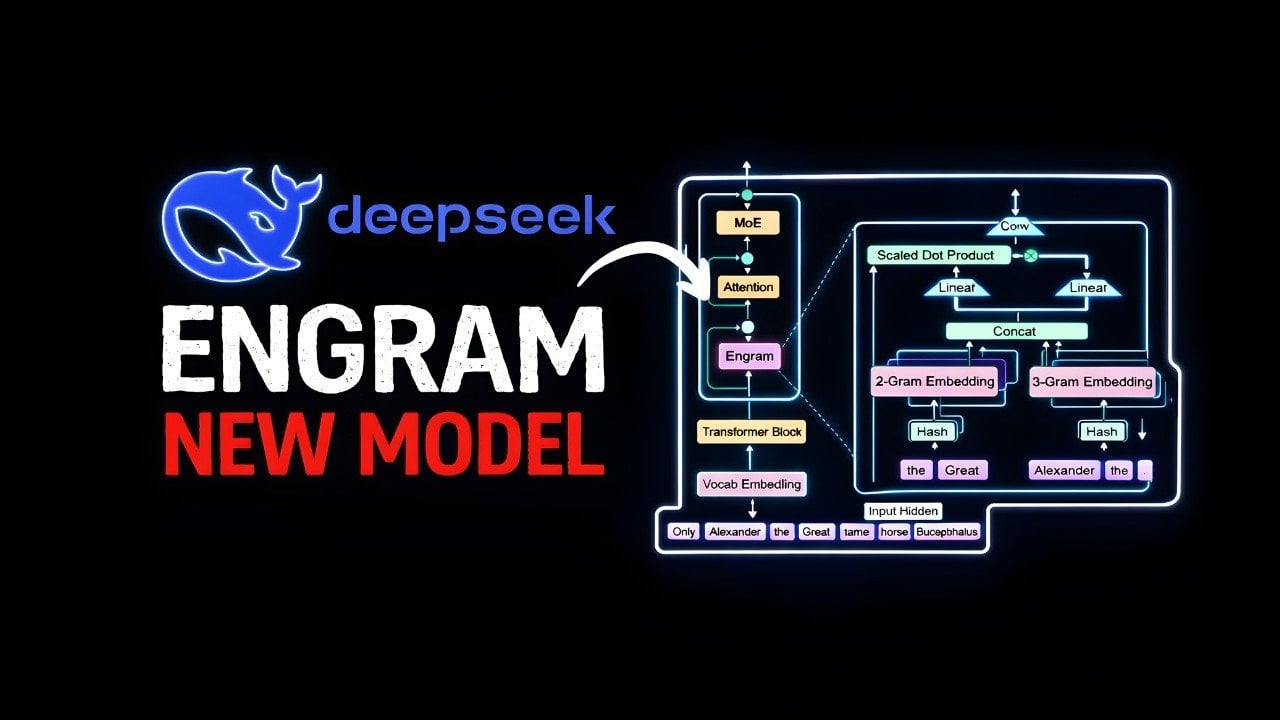

Czy wszechobecne transformery naprawdę są szczytowym osiągnięciem w dziedzinie sztucznej inteligencji? A może stanowią jedynie przeszacowane rozwiązanie prostych problemów? W świecie AI pojawia się nowa, prowokacyjna koncepcja od DeepSeek o nazwie Engram, która podważa fundamenty obecnie dominujących architektur. Jej twórcy sugerują, że transformery można postrzegać po prostu jako bardzo drogie funkcje skrótu. Kluczem do rewolucji jest rozdzielenie mechanizmów odpowiedzialnych za błyskawiczne przywoływanie informacji od tych, które wykonują skomplikowane operacje logiczne. To podejście nie tylko minimalizuje marnotrawstwo mocy obliczeniowej, ale także na nowo definiuje pojęcia skalowalności i szybkości w kontekście dużych modeli językowych (LLM).

Podstawowy problem z architekturą transformer

Obecne modele językowe oparte na architekturze transformer traktują każde zadanie z takim samym poziomem złożoności obliczeniowej. Nie ma dla nich znaczenia, czy pytanie dotyczy podstawowej informacji, takiej jak stolica Francji, czy wymaga rozwiązania skomplikowanego problemu matematycznego. Do obu tych zadań angażują pełną głębię swoich wielu warstw neuronowych. To jednolite podejście prowadzi do poważnych nieefektywności. Proste zadania odwołania się do pamięci niepotrzebnie obciążają cały model, co znacząco podnosi koszty obliczeniowe i stawia granice skalowalności. W miarę jak modele stają się większe i bardziej złożone, te ograniczenia stają się coraz bardziej dotkliwe, utrudniając ich praktyczne wdrożenie w rzeczywistych scenariuszach.

Innowacyjne rozwiązanie DeepSeek Engram

Architektura Engram odpowiada na te wyzwania poprzez wprowadzenie mechanizmu warunkowej pamięci. Jej sednem jest inteligentne rozdzielenie zadań na dwie ścieżki przetwarzania, analogicznie do podziału poznawczego obserwowanego u ludzi. Zamiast przepuszczać wszystko przez głębokie sieci neuronowe, Engram decyduje, która operacja jest w danej chwili potrzebna.

Dwie ścieżki przetwarzania

System opiera się na dwóch kluczowych komponentach. Po pierwsze, statyczne zadania pamięciowe, czyli proste przywoływanie faktów, są obsługiwane za pomocą szybkich odwołań do tablic mieszających (hash-based lookups). Pozwala to całkowicie pominąć głębokie obliczenia transformerów, oszczędzając cenne zasoby. Po drugie, dynamiczne zadania wymagające rozumowania, wnioskowania lub kreatywności są kierowane do klasycznych warstw transformerów, które zapewniają dokładne i kontekstowo świadome odpowiedzi. Decyzję o wyborze ścieżki podejmuje mechanizm bramkowania uwzględniający kontekst, który ocenia złożoność zapytania i dopasowuje do niego odpowiednią metodę przetwarzania.

Zasada działania Engram

W praktyce Engram analizuje tekst wejściowy, wyodrębniając z niego kombinacje tokenów, zwane n-gramami. Te sekwencje są następnie przekształcane za pomocą funkcji skrótu, która wskazuje lokalizację odpowiadających im osadzeń (embeddings) w wcześniej wytrenowanej tablicy przechowywanej w pamięci RAM systemu. Mechanizm bramkowania weryfikuje, czy pobrane osadzenia są istotne w kontekście bieżącego zadania. Dzięki takiej konstrukcji statyczne przypominanie jest odciążone z głównego silnika transformerów, który może skupić się wyłącznie na złożonym rozumowaniu. To nie tylko zwiększa ogólną wydajność, ale także znacząco redukuje opóźnienia podczas wnioskowania.

Wymierne korzyści i poprawa wydajności

Przedstawiona architektura przynosi konkretne korzyści, potwierdzone wynikami benchmarków. Poprawa jest widoczna w kilku kluczowych obszarach.

Lepsze wyniki w testach wiedzy i rozumowania

W zadaniach sprawdzających przywoływanie wiedzy, takich jak MMLU czy ARC AGI, Engram osiąga wyższą dokładność przy mniejszym obciążeniu obliczeniowym. Jednocześnie, uwolniona moc transformerów pozwala na lepsze wyniki w skomplikowanych zadaniach matematycznych i logicznych. Model osiąga głębsze i dokładniejsze przetwarzanie bez konieczności zwiększania liczby warstw neuronowych, co przekłada się na szybsze wykonywanie zadań i lepszą skalowalność.

Optymalizacja wykorzystania sprzętu

Podejście Engram ma bezpośredni, pozytywny wpływ na wymagania sprzętowe. Przechowywanie tablic odnośników w systemowej pamięci RAM odciąża znacznie droższą pamięć GPU, co prowadzi do redukcji kosztów infrastruktury. Ponadto, wstępne pobieranie osadzeń w trakcie obliczeń minimalizuje wąskie gardła i zapewnia płynniejsze działanie. Te optymalizacje obniżają próg wejścia dla organizacji chcących wdrażać zaawansowane modele językowe na dużą skalę, czyniąc zaawansowaną AI bardziej dostępną.

Wyzwania i ograniczenia nowej architektury

Mimo obiecujących wyników, koncepcja Engram nie jest pozbawiona wad i ograniczeń, które wymagają dalszych badań.

Jednym z głównych problemów są potencjalne kolizje mieszające, które mogą wprowadzać niedokładności, szczególnie w zadaniach wymagających najwyższej precyzji. Kolejnym wyzwaniem jest statyczność tablic odnośników – po wstępnym treningu nie mogą one być dynamicznie aktualizowane w trakcie wnioskowania, co ogranicza elastyczność modelu w niektórych scenariuszach. Ponadto, zależność od n-gramów może utrudniać uchwycenie bardzo złożonych lub długodystansowych zależności w danych wejściowych. Wreszcie, skuteczność Engram w wyspecjalizowanych lub niszowych domenach nie została jeszcze dogłębnie przetestowana, pozostawiając pole do dalszej eksploracji.

Szersze implikacje dla przyszłości AI

Architektura Engram nie jest jedynie technicznym usprawnieniem. Jej filozofia czerpie inspirację z ludzkiej kognitywistyki, odzwierciedlając podział na szybkie, automatyczne myślenie (System 1) i powolne, refleksyjne rozumowanie (System 2). To podejście reprezentuje znaczący krok ewolucyjny w projektowaniu LLM, o skali porównywalnej z wprowadzeniem niegdyś mechanizmów uwagi (attention).

Dopasowując metodę obliczeniową do specyfiki zadania, Engram toruje drogę dla bardziej efektywnych, tańszych i łatwiej skalowalnych systemów AI. Jej wpływ może wykroczyć poza same modele językowe, kształtując przyszłe innowacje poprzez nacisk na optymalizację zasobów i przetwarzanie zorientowane na konkretny typ zadania. To nie tylko kwestia wydajności, ale także nowego paradygmatu projektowania inteligentnych systemów.

DeepSeek Engram stawia ważne pytanie o przyszłość fundamentów AI. Czy transformery pozostaną niekwestionowanym standardem, czy też ulegną hybrydyzacji lub nawet zastąpieniu przez architektury lepiej rozróżniające typy operacji umysłowych? Chociaż nowe rozwiązanie ma swoje ograniczenia, jego pojawienie się sygnalizuje dojrzałość dziedziny, w której krytyczna analiza podstawowych założeń prowadzi do przełomowych innowacji. Engram może być zarówno kamieniem milowym, jak i inspiracją dla kolejnych, jeszcze sprawniejszych systemów sztucznej inteligencji.