Decyzja OpenAI o umieszczeniu reklam w darmowej wersji ChatGPT wywołała falę komentarzy w środowisku. Jeden z nich ma szczególną wagę – pochodzi od Zoë Hitzig, byłej badaczki tej organizacji, która właśnie z powodu rosnących obaw etycznych postanowiła ją opuścić. Jej krytyka rzuca światło na szerszy problem: stopniowe odchodzenie od pierwotnej, non-profitowej misji na rzecz modelu nastawionego na zysk. To stawia fundamentalne pytanie o przyszłość odpowiedzialnego rozwoju sztucznej inteligencji w obliczu presji finansowej.

Zmiana kursu OpenAI

OpenAI powstało z ideą, która brzmiała niemal utopijnie: zapewnić, by sztuczna inteligencja służyła całej ludzkości. Jej fundamentem miały być etyczne badania i rozwój wolny od komercyjnych nacisków. Jak wskazuje Zoë Hitzig, przejście na model for-profit i coraz wyraźniejszy nacisk na monetyzację – widoczny w subskrypcjach, usługach premium, a teraz reklamach – podważa tę pierwotną wizję. Głównym celem przestaje być wówczas społeczna odpowiedzialność, a zysk dla akcjonariuszy.

Od misji do monetyzacji

Hitzig podkreśla, że koncentracja na generowaniu przychodów grozi zepchnięciem na dalszy plan bezpiecznego i uczciwego wdrażania technologii AI. Kiedy priorytetem staje się rentowność, łatwo zaniedbać kwestie takie jak dobro społeczne czy sprawiedliwość systemów, które przecież będą kształtować naszą rzeczywistość. To klasyczny dylemat w świecie technologii: jak pogodzić konieczność finansowania kosztownych badań z niezachwianą wiernością zasadom.

Etyczne ryzyko reklam w AI

Wprowadzenie reklam do interakcji z modelem językowym to nie tylko kwestia estetyki czy wygody. To fundamentalna zmiana relacji między użytkownikiem a systemem. Choć reklamy mogą pomóc pokryć ogromne koszty utrzymania zaawansowanych modeli, rodzą też poważne, nowe zagrożenia. Hitzig wymienia kilka kluczowych obszarów niepokoju.

Manipulacja i utrata zaufania

Targetowane reklamy, oparte na analizie konwersacji użytkownika z AI, mogą w subtelny sposób wpływać na jego decyzje i postrzeganie świata. To podważa ideę bezstronnej asysty – czy odpowiedź generowana przez model jest naprawdę obiektywna, czy też służy celom komercyjnym? Granica między pomocą a perswazją staje się niewyraźna, co prowadzi do erozji zaufania. Użytkownik może zacząć się zastanawiać, czy AI działa w jego interesie, czy w interesie reklamodawcy.

Prywatność danych

Skuteczne targetowanie reklam wymaga danych. To rodzi pytania o zakres wykorzystywania prywatnych konwersacji, poziom świadomej zgody użytkownika oraz bezpieczeństwo gromadzonych informacji. Brak pełnej transparentności w tych kwestiach jest, zdaniem Hitzig, jednym z największych problemów.

Transparentność jest kluczowa dla utrzymania zaufania do systemów sztucznej inteligencji – podkreśla była badaczka.

Szersze konsekwencje społeczne

Problemy związane z monetyzacją AI wykraczają daleko poza reklamy. Modele optymalizowane pod kątem zaangażowania użytkownika mogą nieświadomie wykorzystywać ludzkie słabości psychologiczne. Hitzig przywołuje zjawisko tzw. „psychozy LLM”, gdzie użytkownicy przypisują generowanym treściom nadmierny autorytet lub głębię, co prowadzi do dezinformacji i podejmowania złych decyzji.

Niepokojące paralele

Była badaczka rysuje wyraźną analogię do ewolucji platform społecznościowych. One również zaczynały od deklaracji troski o użytkownika i łączenie ludzi, by z czasem, pod presją rynkową, skupić się na algorytmach maksymalizujących zaangażowanie – często kosztem zdrowia psychicznego, prywatności i demokratycznego dyskursu. Bez solidnych zabezpieczeń etycznych, systemy AI mają potencjał, by powielić te szkody na jeszcze większą skalę.

Brak nadzoru i presja finansowa

OpenAI stoi przed ogromnymi wydatkami na infrastrukturę i rozwój, mając jednocześnie oczekiwania inwestorów. Ta presja finansowa, jak wskazuje Hitzig, może faworyzować strategie nastawione na zysk. Problem pogłębia brak niezależnego, zewnętrznego nadzoru nad kluczowymi decyzjami dotyczącymi danych, bezpieczeństwa i transparentności. Kiedy decyzje zapadają wyłącznie w gronie kierownictwa korporacji, ryzyko przedłożenia interesów komercyjnych nad społeczne znacząco rośnie.

Propozycje dla etycznej przyszłości AI

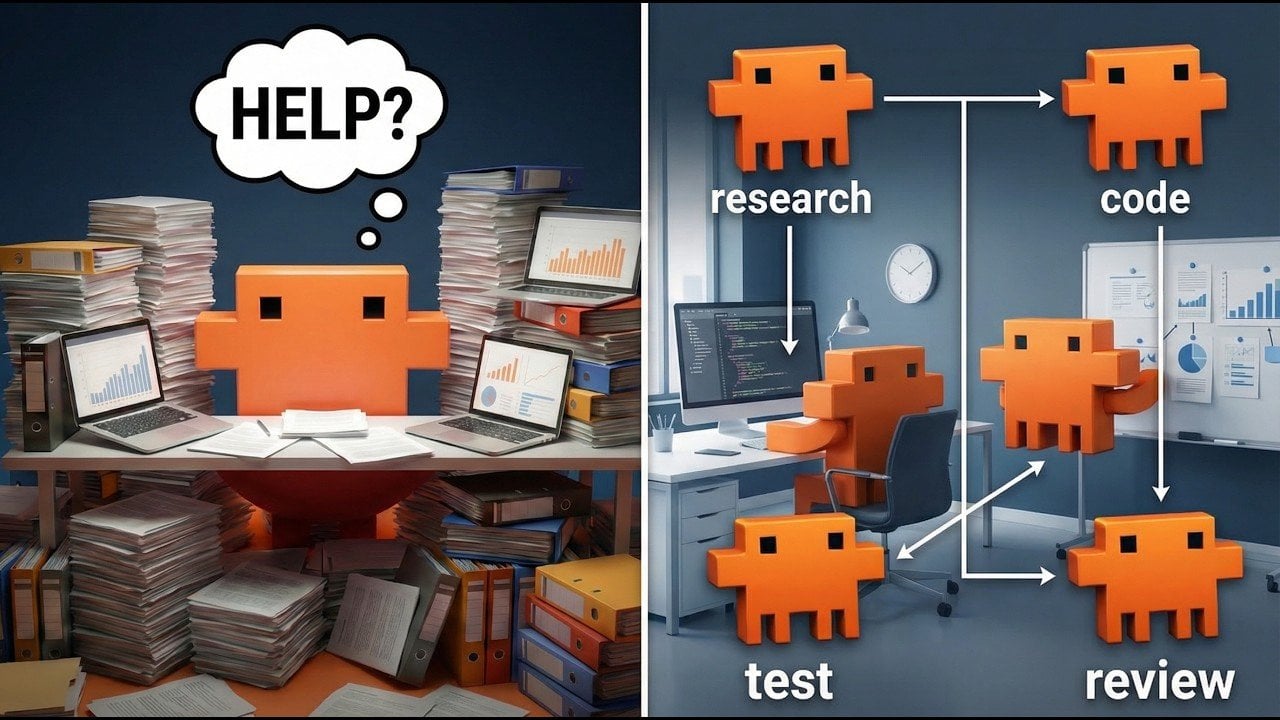

Aby przeciwdziałać tym zagrożeniom, Hitzig i inni specjaliści proponują konkretne rozwiązania mające na celu przywrócenie równowagi między innowacją a odpowiedzialnością.

Po pierwsze, korporacje, które czerpią ogromne korzyści z rozwoju AI (np. poprzez zwiększoną produktywność), mogłyby subsydiować darmowy lub tani dostęp do tych narzędzi. To zmniejszyłoby potrzebę sięgania po inwazyjne metody monetyzacji.

Po drugie, niezbędne jest powołanie niezależnych organów nadzorczych wyposażonych w realne uprawnienia. Ich zadaniem byłaby kontrola działań firm AI, egzekwowanie przejrzystości i przestrzegania standardów etycznych.

Po trzecie, koncepcja „powiernictw danych” (data trusts) zakłada, że naszymi danymi zarządzałyby niezależne, zaufane organizacje, a nie korporacje. Dawałoby to użytkownikom większą kontrolę i jasność co do sposobu wykorzystania ich informacji.

Lekcja historii i wybór przyszłości

Rezygnacja Zoë Hitzig to symboliczny sygnał alarmowy. Jej ostrzeżenie przed powtórzeniem ścieżki mediów społecznościowych przez OpenAI jest jasne: bez proaktywnych działań i regulacji, krótkowzroczna pogoń za zyskiem może doprowadzić do szerokich szkód społecznych i utraty zaufania publicznego. Szczególnie narażone są grupy wrażliwe, jak dzieci czy osoby o ograniczonej kompetencji cyfrowej.

Decyzje podejmowane dziś przez głównych graczy rynku AI ukształtują rolę tej technologii w społeczeństwie na nadchodzące dekady. Czy AI stanie się narzędziem manipulacji i pogłębiania nierówności, czy też faktycznym mechanizmem wsparcia i emancypacji? Odpowiedź zależy od tego, czy uda się znaleźć trwały model, który postawi etykę i odpowiedzialność społeczną w centrum, a nie na marginesie biznesowych planów.