W świecie natychmiastowych informacji sztuczna inteligencja stała się potężnym narzędziem do kreowania alternatywnej rzeczywistości. Ostatnie wydarzenia wokół aresztowania prezydenta Wenezueli, Nicolása Maduro, dobitnie pokazują, jak szybko generowane przez AI treści potrafią zalać media społecznościowe, zdobywając miliony zaangażowań i wprowadzając chaos informacyjny. Eksperci ds. dezinformacji alarmują, że tradycyjne oznaki fałszerstw, oparte na analizie wizualnej, przestają być wiarygodne.

Sztuczna inteligencja wypełnia informacyjną próżnię

Gdy tylko Donald Trump ogłosił wiadomość o zatrzymaniu Maduro, w sieci pojawiła się lawina obrazów i nagrań, które miały dokumentować to wydarzenie. Wiele z nich zostało stworzonych przez algorytmy sztucznej inteligencji. Jak wyjaśnia Benjamin Dubow, analityk z Center for European Policy Analysis (CEPA), tego typu treści powstają, aby wypełnić lukę informacyjną w pierwszych, kluczowych godzinach po przełomowym wydarzeniu.

Zapotrzebowanie na natychmiastowe wizualizacje

W sytuacji braku oficjalnych zdjęć czy relacji z miejsca zdarzenia, użytkownicy mediów społecznościowych chętnie przyjmują każdą, nawet sfabrykowaną wizualizację. „Masz jedną z największych, najbardziej szokujących historii ostatnich lat, a przez kilka godzin po jej ogłoszeniu nie ma prawie żadnych wiarygodnych wiadomości, ponieważ panuje duża niepewność” – mówi Dubow. To właśnie w tej próżni generowane przez AI filmy i zdjęcia zyskują ogromny zasięg, podsycając narrację i kształtując pierwsze wrażenia.

Przypadek wirusowych fałszywek

Jedno z najgłośniejszych nagrań, które zdobyło miliony wyświetleń, przedstawiało Wenezuelczyków klęczących i dziękujących Trumpowi oraz Stanom Zjednoczonym za uwolnienie spod rządów Maduro. Materiał, pierwotnie opublikowany na TikToku przez konto „Curious Mind”, został następnie udostępniony na platformie X przez Elona Muska, co znacząco zwiększyło jego zasięg.

Błędy ujawniające mistyfikację

Wnikliwi obserwatorzy szybko zauważyli nieścisłości w filmie: nieprawidłowe wzory na flagach, znikające obiekty czy brakujące zęby u postaci. Społeczność X dodała do posta adnotację, informującą, że materiał jest generowany przez AI i służy wprowadzaniu w błąd. Mimo to, podobne „sztuczne śmieci” (ang. AI slop), w tym deepfake przedstawiający Maduro tańczącego breakdance z Trumpem, wciąż krążyły po platformie.

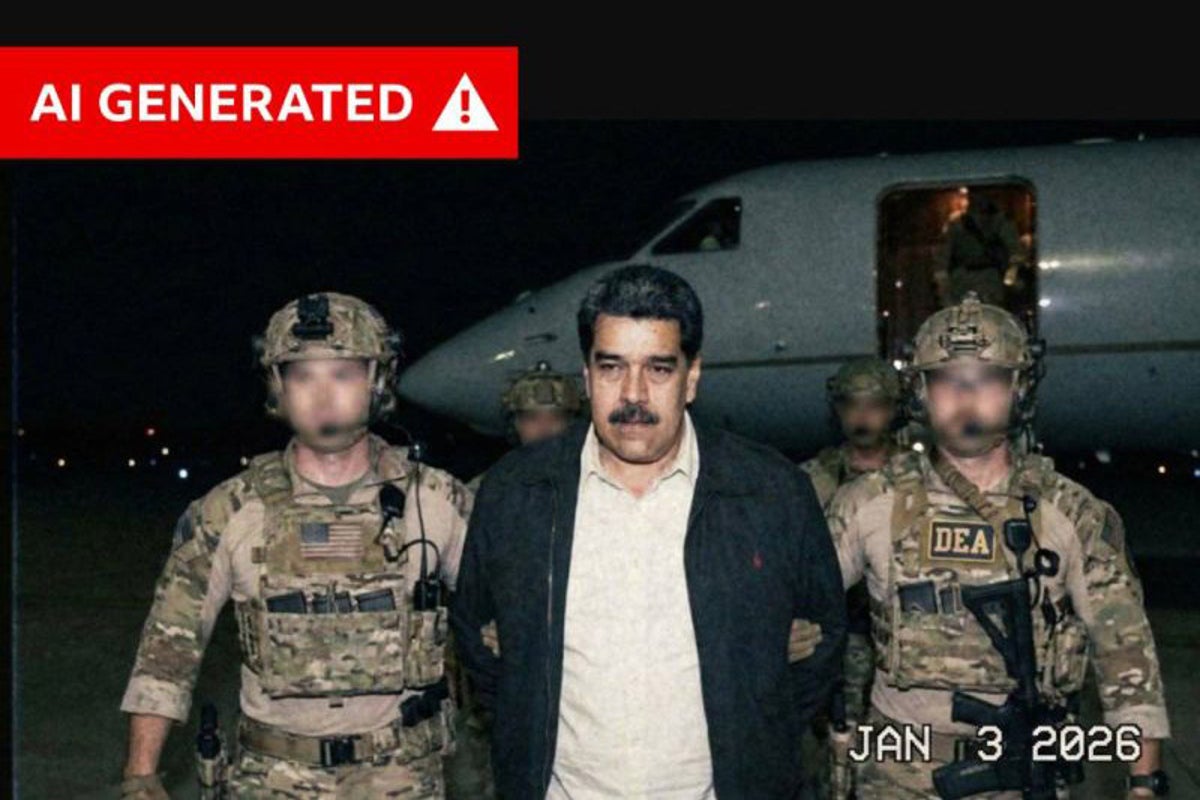

Hiperrealistyczne zdjęcie w oficjalnym komunikacie

Inny, niezwykle realistyczny obraz, wygenerowany prawdopodobnie za pomocą Google Gemini, przedstawiał Maduro prowadzonego przez amerykańskich agentów. To zdjęcie wykorzystał w swoim oficjalnym wpisie na Instagramie Vince Lago, burmistrz Coral Gables na Florydzie, chwaląc działania administracji Trumpa. Analiza narzędzia SynthID od Google ujawniła na obrazie niewidzialny dla ludzkiego oka znak wodny, potwierdzający jego sztuczne pochodzenie.

„W miarę jak obrazy i filmy generowane przez AI doskonalą się do punktu, w którym wskazówki wizualne przestają być wiarygodne, ważniejsze niż kiedykolwiek jest podchodzenie z sceptycyzmem do treści w mediach społecznościowych, nawet gdy udostępniają je prominentne lub zweryfikowane konta” – mówi Sofia Rubinson, starsza redaktorka NewsGuard.

Stare nagrania i manipulacja kontekstem

Problem nie ogranicza się wyłącznie do treści tworzonych od zera przez sztuczną inteligencję. Równie powszechną taktyką jest wykorzystywanie autentycznych, lecz przestarzałych nagrań, wyjętych z pierwotnego kontekstu. Nawet Donald Trump udostępnił na Truth Social film, rzekomo pokazujący Wenezuelczyków świętujących upadek reżimu Maduro. Tymczasem reverse image search ujawnił, że było to nagranie z protestów w Caracas z lipca 2024 roku.

Powielanie przez wpływowe osoby

Ten sam materiał został później powielony przez Alexa Jonesa, wpływowego prawicowego twórcę teorii spiskowych, który przedstawił go swojej wielomilionowej publiczności jako dowód na „usunięcie komunistycznego dyktatora”. Tego typu działania pokazują, jak łatwo stare nagrania mogą zostać przeinaczone i użyte do wsparcia bieżącej narracji politycznej, wprowadzając zamęt i utrudniając odbiorcom dotarcie do prawdy.

Jak się bronić w erze deepfake’ów?

W obliczu zalewu treści, zarówno generowanych przez AI, jak i celowo dekontekstualizowanych, podstawowa umiejętność krytycznej oceny mediów (media literacy) staje się kluczowa. Benjamin Dubow podkreśla, że fundamentalne zasady weryfikacji informacji wcale się nie zmieniły, choć skala wyzwania jest nieporównywalnie większa.

Zasady weryfikacji i zdrowy sceptycyzm

Eksperci zalecają kilka podstawowych kroków: – Czekanie na potwierdzenie ze strony wiarygodnych, renomowanych źródeł informacji. – Weryfikację pochodzenia materiału i daty jego powstania. – Szczególną ostrożność wobec treści, które idealnie wpasowują się w nasze istniejące poglądy.

„Powinieneś być najbardziej podejrzliwy wobec treści, z którymi się najbardziej zgadzasz” – radzi Dubow. – „To, co wydaje się idealnie pasować do twojego światopoglądu, najłatwiej może cię oszukać. Nigdy nie uwierzysz w coś, co dobrze przedstawia drugą stronę, więc dezinformacja przeciwnika tak naprawdę cię nie dotknie”.

Podsumowując, incydent z fałszywymi nagraniami o Maduro to kolejny dzwonek alarmowy. Sztuczna inteligencja nie tylko tworzy coraz doskonalsze mistyfikacje, ale też błyskawicznie wykorzystuje momenty kryzysu informacyjnego. W odpowiedzi niezbędna jest połączenie zaawansowanych narzędzi detekcyjnych, odpowiedzialności platform społecznościowych oraz – przede wszystkim – czujności i krytycznego myślenia każdego użytkownika sieci. Zaufanie do tego, co widzimy w mediach społecznościowych, gwałtownie maleje, a odbudowa tego zaufania wymaga zbiorowego wysiłku.